Red Hat anunció la expansión de su colaboración con Amazon Web Services (AWS) para impulsar soluciones empresariales de Inteligencia Artificial generativa (IA gen) en AWS a través de Red Hat AI y los chips de IA de AWS.

Con esta colaboración, Red Hat busca empoderar a los responsables de la toma de decisiones de TI con la flexibilidad necesaria para ejecutar inferencia de IA de alto rendimiento y eficiente a escala, independientemente del hardware subyacente.

El auge de la IA gen y la consecuente necesidad de inferencia escalable están llevando a las organizaciones a reevaluar su infraestructura de TI. Como resultado, IDC predice que “Para 2027, el 40% de las organizaciones utilizará silicio personalizado, incluidos procesadores ARM o chips específicos para AI/ML, para satisfacer las crecientes demandas de optimización del rendimiento, eficiencia de costos y computación especializada.”.

Esta tendencia refuerza la necesidad de soluciones optimizadas para mejorar la capacidad de procesamiento, minimizar los costos y permitir ciclos de innovación más rápidos para aplicaciones de IA de alto rendimiento.

La colaboración de Red Hat con AWS empodera a las organizaciones con una estrategia completa de IA gen, al unir una vasta biblioteca de recursos de plataforma de Red Hat con la infraestructura de nube y los chipsets de IA de AWS: AWS Inferentia y AWS Trainium.

Joe Fernandes, vicepresidente y gerente general de la Unidad de Negocios de IA, Red Hat dijo: “Al habilitar el Red Hat AI Inference Server para el sector empresarial, desarrollado sobre el innovador framework vLLM, con chips de IA de AWS, estamos empoderando a las organizaciones para desplegar y escalar cargas de IA con mayor eficiencia y flexibilidad. Basada en la herencia de código abierto de Red Hat, esta colaboración busca hacer que la IA generativa sea más accesible y económicamente viable en entornos de nube híbrida.”

Por su parte, Colin Brace, vicepresidente de Annapurna Labs, AWS, afirmó: “Las empresas exigen soluciones que ofrezcan un rendimiento excepcional, rentabilidad y opciones operativas para cargas de trabajo de IA de misión crítica. AWS diseñó sus chips Trainium e Inferentia para hacer que la inferencia y el entrenamiento de IA de alto rendimiento sean más accesibles y económicos. Nuestra colaboración con Red Hat ofrece a los clientes un camino estructurado para desplegar IA generativa a escala, combinando la flexibilidad del código abierto con la infraestructura de AWS y aceleradores de IA desarrollados específicamente para acelerar el retorno de la inversión, desde el piloto hasta la producción.”

Los aspectos clave de esta nueva fase de la asociación incluyen:

● Red Hat AI Inference Server en chips de IA de AWS: el Red Hat AI Inference Server, basado e impulsado por vLLM, estará habilitado para ejecutarse con los chips de IA de AWS, incluidos AWS Inferentia2 y AWS Trainium3, para ofrecer una capa de inferencia común, capaz de soportar cualquier modelo de IA gen, brindando más rendimiento, menor latencia y mejor rentabilidad al escalar despliegues de IA en producción, con una eficiencia hasta un 30-40% superior a las instancias Amazon EC2 basadas en GPU actualmente comparables.

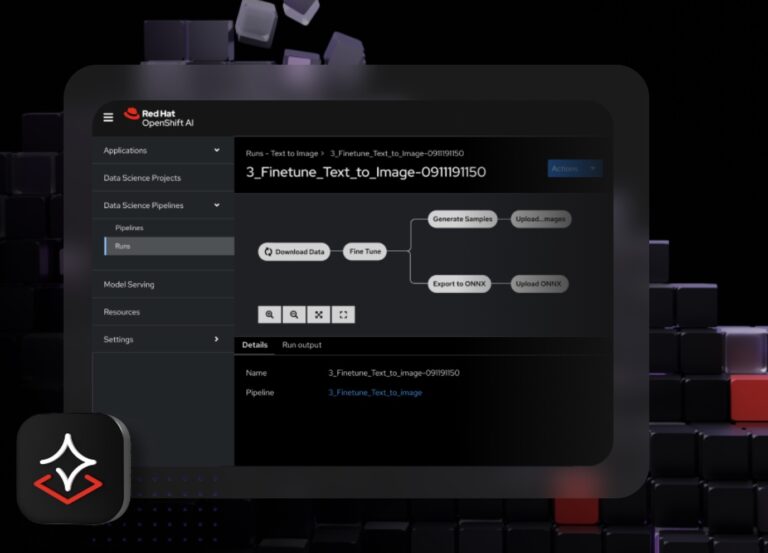

● Habilitando la IA en Red Hat OpenShift: Red Hat trabajó con AWS para desarrollar un operador de AWS Neuron para Red Hat OpenShift, Red Hat OpenShift AI y Red Hat OpenShift Service on AWS, una plataforma de aplicaciones completa y totalmente administrada en la base de Amazon, proporcionando a los clientes una ruta más simple y con soporte para ejecutar sus cargas de trabajo de IA con aceleradores de AWS.

● Facilidad de acceso y despliegue: al ofrecer soporte a los chips de IA de AWS, Red Hat proporcionará un acceso mejorado y simplificado a aceleradores de alta demanda y alta capacidad para clientes de Red Hat en AWS. Además, Red Hat lanzó recientemente la Colección Ansible Certificada amazon.ai para la Plataforma de Automatización Red Hat Ansible, entorno en el que es posible orquestar servicios de IA en AWS.

● Contribución con la comunidad upstream: Red Hat y AWS están colaborando para optimizar un plugin de chip de IA de AWS para que esté disponible upstream en vLLM. Como principal colaboradora comercial de vLLM, Red Hat está comprometida a habilitar vLLM en AWS con el fin de acelerar las capacidades de inferencia y entrenamiento de IA para los usuarios. vLLM también tiene como arquitectura técnica a llm-d, proyecto de código abierto enfocado en ofrecer inferencia a escala, ahora disponible como recurso comercial en Red Hat OpenShift AI 3.

Red Hat tiene un largo historial de colaboración con AWS para empoderar a los clientes desde el centro de datos hasta el edge. Este nuevo hito busca satisfacer las necesidades en evolución de las organizaciones a medida que integran la IA en sus estrategias de nube híbrida para lograr resultados de IA gen optimizados y eficientes.